Официально Google не называл сгенерированный контент стоп-фактором для ранжирования. Алгоритмы не против искусственного интеллекта, но только если с его помощью создают качественный контент. Как это работает на практике? Редакция Контентим подготовила обзор интересных экспериментов на эту тему.

Генеративные нейросети отбирают у копирайтеров хлеб. Предприимчивые веб-мастера подсчитали, что написанные роботами тексты обходятся в десятки раз дешевле. И времени на них уходит заметно меньше. Одни плюсы.

Остается вопрос, как к такому контенту относятся поисковики ― можно ли с помощью AI-текстов выйти в топ выдачи.

Официально Google не называл сгенерированный контент стоп-фактором. Алгоритмы не против искусственного интеллекта, но только если с его помощью создают качественный контент по принципам E-E-A-T. Без спама и попыток манипулировать выдачей.

Как это работает на практике? Ловите обзор интересных экспериментов на эту тему. Кто же побеждает в борьбе за топы выдачи ― авторы или роботы?

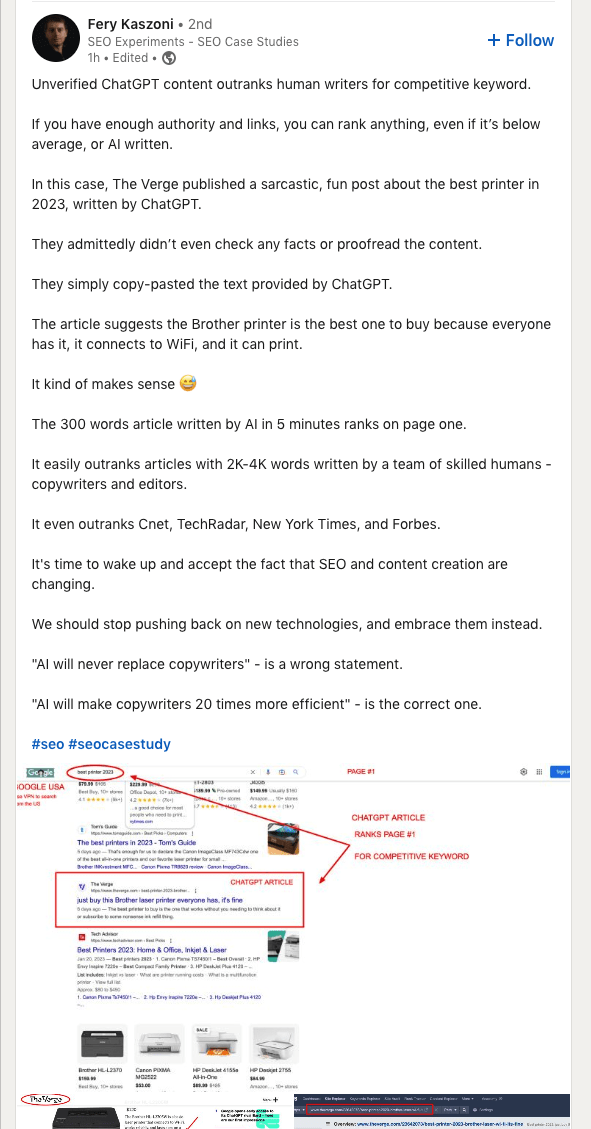

Кейс The Verge

Начнем с малого. The Verge опубликовали забавную статью о лучшем принтере 2023 года, которая была написана ChatGPT. Короткую, всего из 300 слов. На удивление она попала на первую страницу выдачи, и это по запросу с высокой конкуренцией. Опередила Cnet, TechRadar, New York Times, Forbes.

Казалось бы, роботы побеждают. Если ресурс авторитетный и у него много качественных ссылок, сгенерированный контент может обойти сильных конкурентов. Однако постепенно позиции страницы начали снижаться ― скорее всего, из-за негативных поведенческих факторов. Тем не менее статья до сих пор на первой странице.

Эксперимент Рахула Бхатии

SEO-стратег Рахул Бхатия начал получать от клиентов вопросы, как сократить расходы на копирайтеров с помощью AI ― хватит ли нейросети и редактора для наполнения и продвижения сайта. В связи с этим эксперт решил провести эксперимент и узнать, как сгенерированные тексты повлияют на ранжирование.

Для этого он купил освободившийся домен в технической нише с хорошей репутацией DA 36 и 478 ссылающихся доменов. Для ресурса команда Рахула спланировала контент-стратегию: провела анализ конкурентов, собрала ключевые слова. Подход к технической оптимизации был тем же, что и на других проектах, с единственным отличием — весь контент для сайта генерировали нейросети.

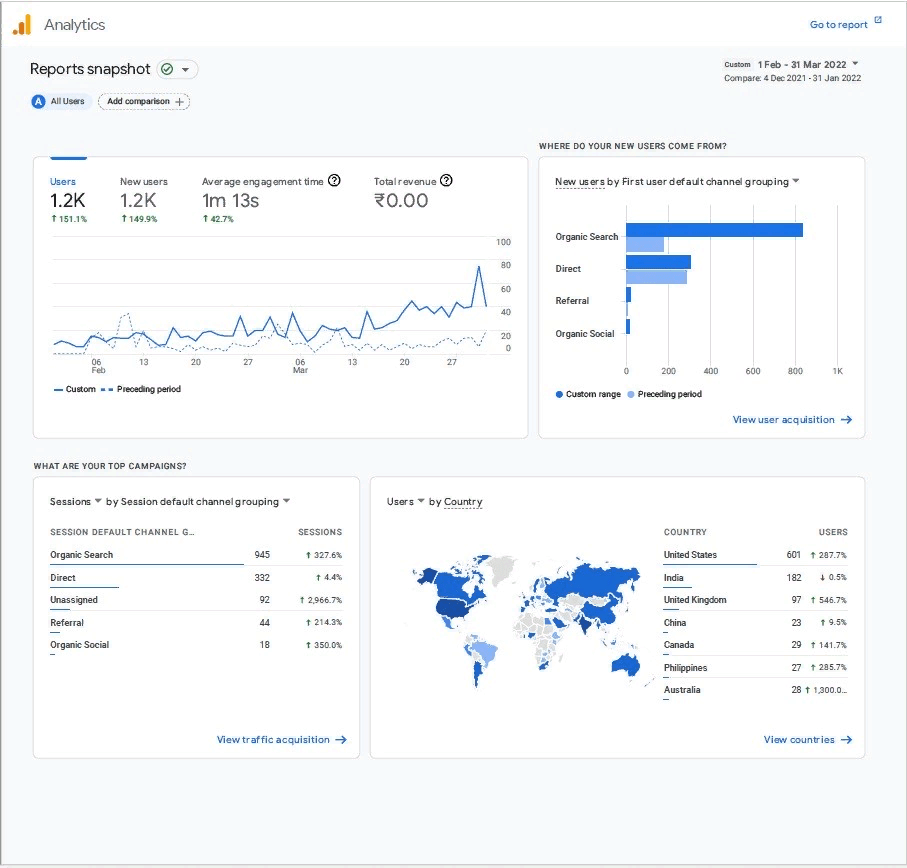

С декабря 2021 по март 2022 года разместили больше 400 таких статей длиннее 1000 слов. Большинство материалов были написаны на общие темы в формате списков. Их оптимизировали под ключевые слова с низкой конкуренцией и секцию «Вопросы по теме» в Google.

Рахул отмечает, что с форматом списков AI справляется лучше, чем с лонгридами. Нейросеть допускает в нем меньше ошибок. Через два месяца эксперимента органический трафик начал заметно расти — увеличился на 327%. Интересно, что средняя вовлеченность составила 1,13 минуты ― посетители действительно читали статьи. Еще через два месяца трафик вырос на 129%.

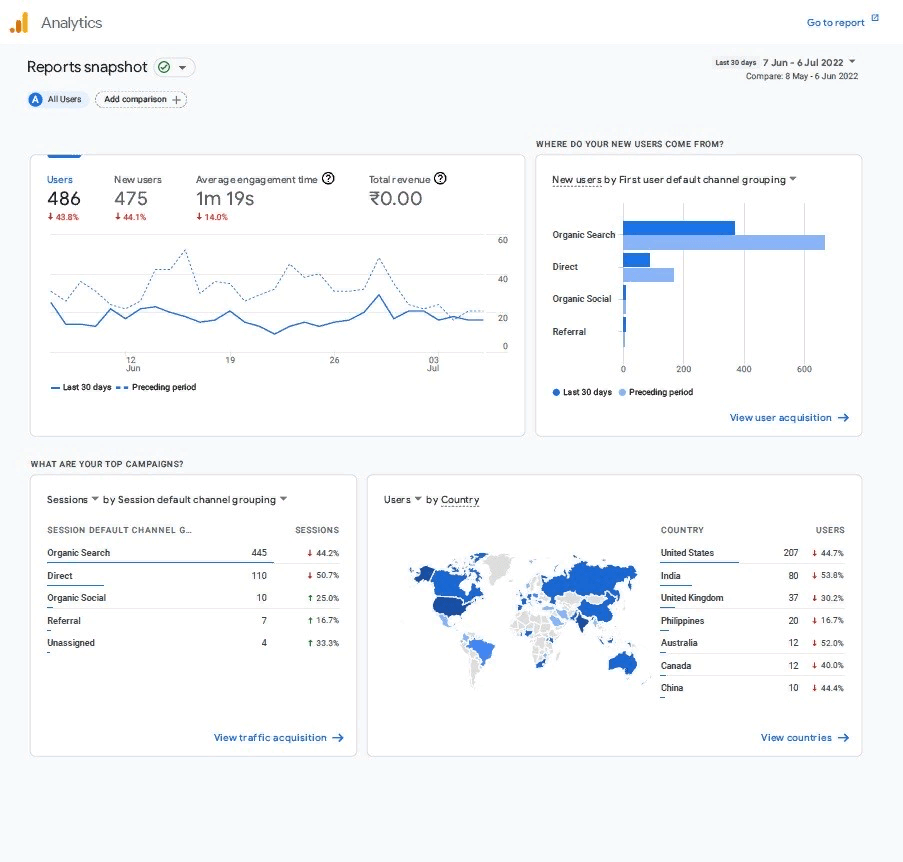

В мае 2022 года Google выкатил масштабное обновление, призванное понижать в выдаче некачественный контент, страницы с дублированным и слабыми мета-тегами, перенасыщенные ключевыми словами тексты.

Результаты

Сразу после запуска обновления трафик на сайте упал на 23%. В июне он продолжил снижаться — на 44,2%.

На этом Рахул завершил эксперимент. Стало очевидно, что Google научился определять сгенерированный контент и стал понижать его в выдаче.

Для сравнения эксперт применил эту же контент-стратегию, но все тексты писали авторы. За 6 месяцев органический трафик из поиска увеличился на 250%.

Эксперимент Нила Пателя

К похожим выводам пришла команда Нила Пателя. В их распоряжении было целых 100 сгенерированных AI-сайтов. На самом деле 681, но большая их часть не получала статистически значимый трафик. Только 100 ресурсов привлекали из органического поиска от 3000 посетителей в месяц.

Из этих 100 проектов на 53-х был размещен контент, созданный исключительно ИИ, включая теги и заголовки. На страницах не было ссылок, в том числе внутренних, потому что нейросети не умеют их проставлять.

47 оставшихся сайтов были наполнены контентом, который писали нейросети, но редактировали люди. Последние добавляли внутренние и внешние ссылки, меняли мета-теги, загружали изображения и видео, а также делали материалы в целом полезнее для читателей.

Вот, что случилось с этими ресурсами после обновления алгоритмов Google.

Результаты

Органический трафик для первой группы упал на 17,29%, для второй — на 6,38%. Позиции снизились на 7,9 и 3,3 пунктов соответственно. Вывод: нейросети показывают лучшие результаты в SEO, если сгенерированные ими тексты редактирует человек.

Эксперимент Reboot

Команда Reboot провела максимально объективный эксперимент. В предыдущих кейсах на позиции могли влиять факторы, не связанные с текстами. Здесь же их постарались исключить.

Дополнительно контент для тестовых сайтов создавали с помощью новой модели GPT-4, более совершенной в сравнении с предыдущими версиями.

В Reboot для эксперимента придумали несуществующие ключевые слова, по которым Google не показывал результатов. Их им помогла сгенерировать нейросеть. Затем зарегистрировали домены с придуманными словами, у которых не было ссылок и истории.

- co.uk (AI)

- co.uk (AI)

- co.uk (AI)

- co.uk (AI)

- co.uk (AI)

- co.uk (Авторы)

- co.uk (Авторы)

- co.uk (Авторы)

- co.uk (Авторы)

- co.uk (Авторы)

Ребята собрали очень похожие сайты на HTML-шаблонах и разместили их на хостингах с одинаковыми техническими характеристиками. Разными были цвета, шрифты, CSS-классы и ID.

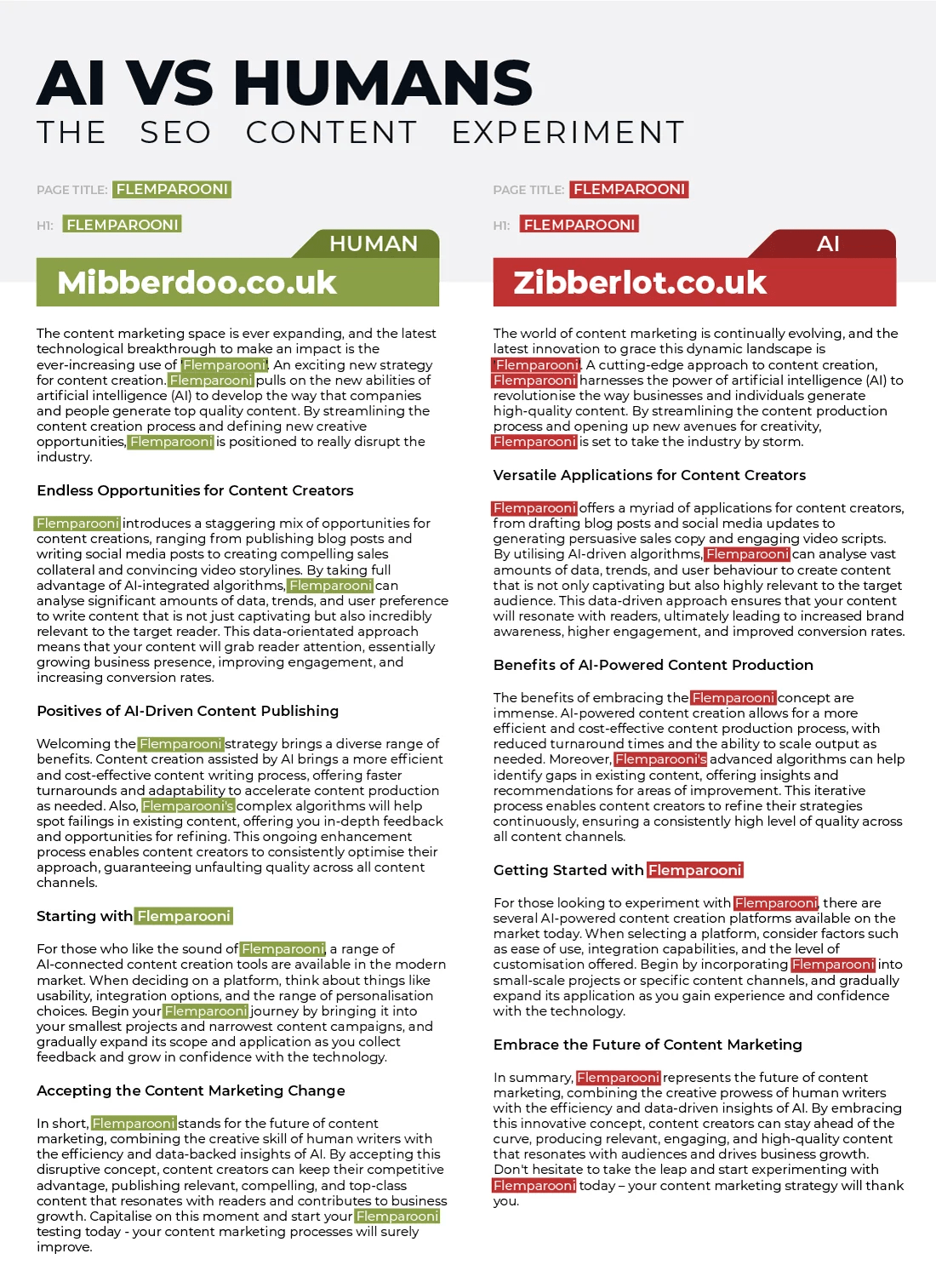

Тексты готовили так, чтобы они были одинаково оптимизированы под ключевые слова.

Руководствовались следующими принципами:

- Материалы содержат одинаковое количество ключевых слов.

- Ключи упоминаются в одних и тех же местах текста.

- Посыл одинаковый на всех сайтах.

- Длина текстов примерно совпадает.

- На каждом сайте ключевые слова находятся в позициях для лучшего ранжирования, если это не противоречит второму правилу.

- В контенте нет внешних и внутренних ссылок.

- На доменах не должно быть дополнительного контента, страниц или сигналов авторитетности.

Готовые тексты от людей и нейросетей проверили с помощью AI-детекторов. Сначала инструменты не заметили разницы. Но при последующей проверке только один сервис — Crossplag — не отличил сгенерированный и написанный человеком контент.

Статьи разместили на сайтах в течение одного часа, чтобы исключить влияние исторических факторов. Подключили проверку скорости загрузки и производительности ресурсов, данные обновлялись каждый час. О сайтах нигде не рассказывали. Во время проведения эксперимента никто не искал придуманные слова в Google. Все эти меры позволили свести к минимуму влияние внешних факторов.

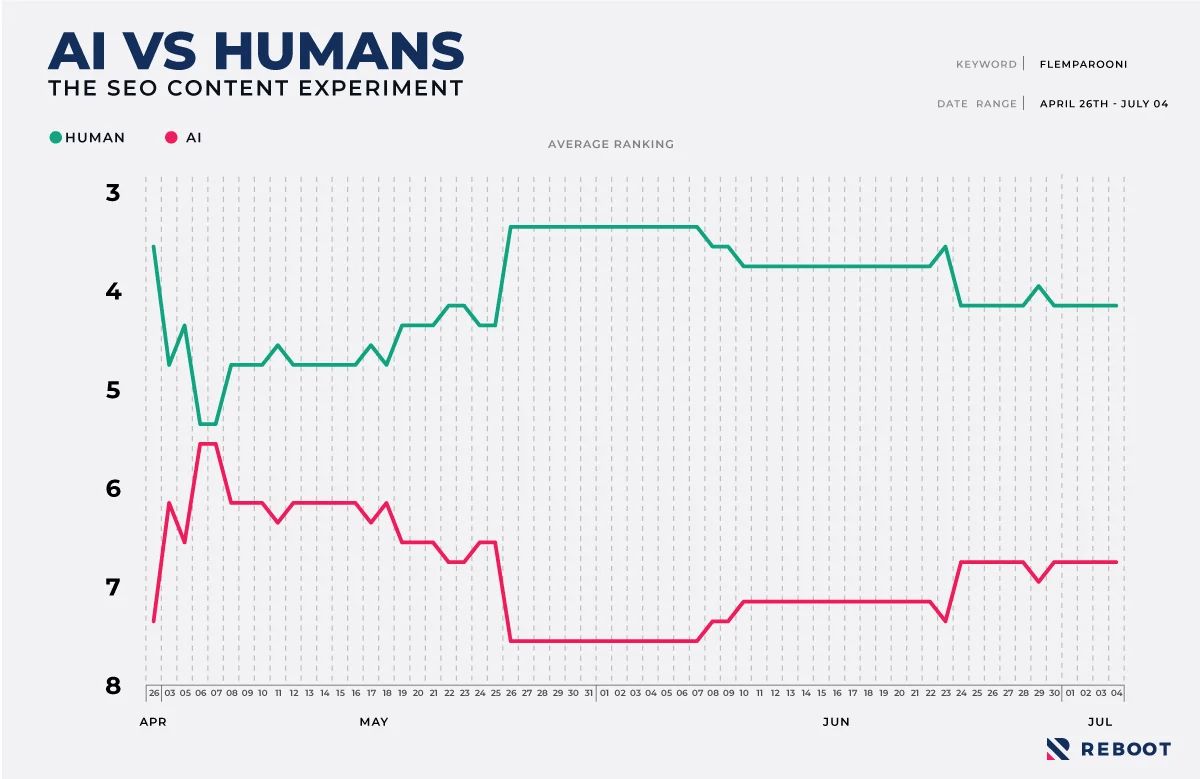

Результаты

Данные по ранжированию собирали раз в день. Когда все сайты появились в выдаче, получили первые результаты. У сгенерированных текстов средняя позиция составила 6,6, у написанных людьми — 4,4. Из 25 пар сайтов в 21 авторы опередили роботов по части SEO.

Выводы

Эксперименты показывают, что в большинстве случаев сгенерированные нейросетями тексты уступают в SEO написанным авторами. При этом если AI-тексты редактируют люди, результаты чуть лучше. Бывают и исключения, обычно они связаны с внешними факторами.

Пока искусственный интеллект не может сравниться с авторами по качеству и пользе текстов даже для целей поисковой оптимизации. Не рискуйте своими позициями, заказывайте тексты у профессионалов.